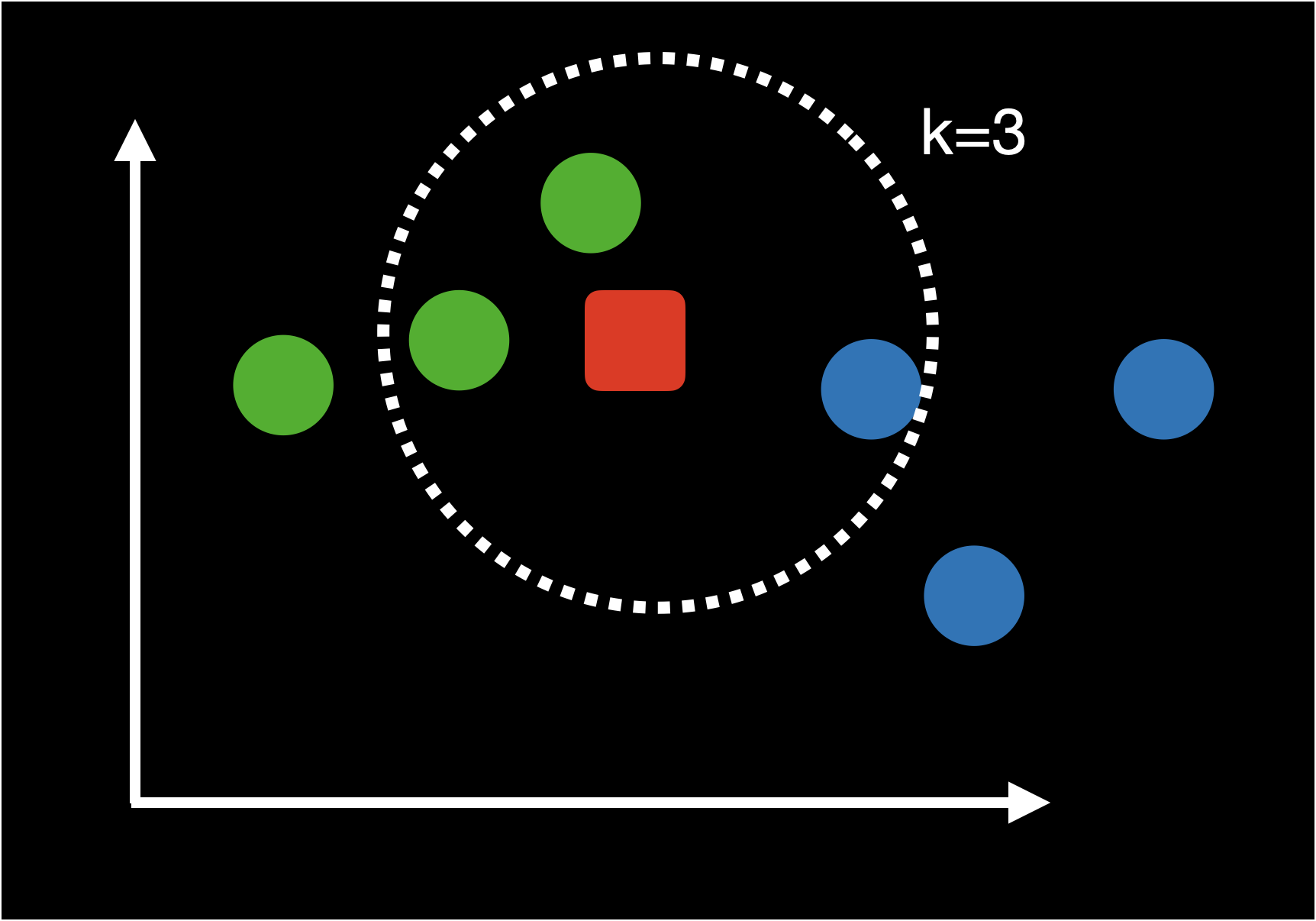

문장 Embedding을 활용하면 문장과 문장 사이의 유사도 혹은 관련성을 벡터 연산을 통해 쉽게 계산할수 있습니다. Transformer Encoder 구조를 활용한 BERT 모델은 입력 문장을 문장 Embedding으로 변환 시킬수 있습니다. 이 BERT 모델을 사용해 문장과 문장 사이의 관계를 계산할수 있는데 이 때 2가지 방법이 있는데 첫번째 바이인코더(Bi-Encoder) 두번째로는 교차인코더(Cross-Encoder) 가 있습니다 Bi-Encoder 바이 인코더 방식은 각각의 문장을 독립적으로 BERT 모델에 입력으로 넣고 출력결과인 문장 임베딩 벡터로 벡터 사이 코사인 유사도를 통해 문장 관계를 계산하는 방식입니다. BERT 다음 Pooling Layer를 넣는 이유는 문장 임베딩 벡터의 차..